Data Science und KI für Frühwarnsysteme in der Beschaffung

[06.07.2021]

Jede Bauteilknappheit auf dem Markt kündigt sich durch Datenspuren an. Mit den richtigen Tools und Methoden nutzen Sie Data Science und smarte Algorithmen, um auf Supply Chain Krisen und Fehlteile besser vorbereitet zu sein. Erfahren Sie, wie ein Lösungsansatz aussehen kann und welche Ergebnisse realistisch sind.

Data Science und KI für Frühwarnsysteme in der Beschaffung

Als sich Ende 2019 der Beginn der COVID-Pandemie abzeichnete, hatte ein kanadisches Computersystem das schon vorausgesagt. Das war keine Zauberei, sondern ein Frühwarnsystem auf der Basis künstlich intelligenter Systeme, welches für Unternehmen und Behörden Prognosen über Infektionskrankheiten erstellt. Das System durchkämmte dafür eine Vielzahl an zugänglichen Informationsquellen wie internationale Medien oder Behördeninformationen und wertete diese aus. Genau dieser Ansatz ließe sich für die Chip-Krise, welche die Bänder bei den großen Automobilisten zum Stillstand brachte, nutzen.

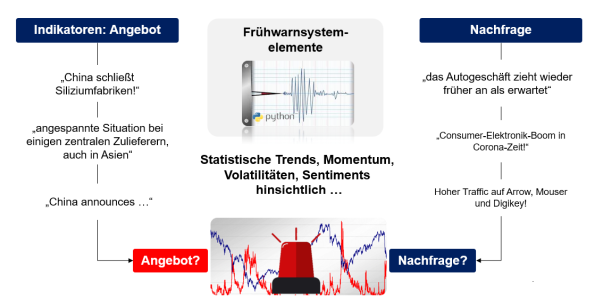

Ein erhöhtes Versorgungsrisiko tritt immer dann auf, wenn sich Angebot und Nachfrage aus dem Gleichgewicht bewegen.

Die Hypothese hierbei ist, dass es schwache Signale gibt, welche ein Ungleichgewicht zwischen Angebot und Nachfrage ankündigen. Man stelle sich nun einen superintelligenten, fiktiven Supply Chain Manager vor. Dieser superintelligente Manager ist fähig, täglich weltweit alle Internetnachrichten zum Thema Halbleiter, Absatzmärkte und Branchennews zu lesen. Das sind viele 1000 Blogs und News-Feeds in USA, Asien und Europa. Gleichzeitig surft er auch auf allen großen Internetmarktplätzen für Elektronikbauteile, nochmal mindestens ein Duzend, wenn er nur die Größten berücksichtigt. Zudem liest er online weltweit alle großen Tageszeitungen, Regionalnachrichten und Fachjournals.

Denn die Schlagzahl, mit der sich die Nachrichten zum steigenden Output der Hersteller von Unterhaltungselektronik erhöhte, hätten ihn vielleicht stutzig gemacht. Wenn er gleichzeitig auf chinesischen Halbleiter-Blogs von umgeschichteten Produktionskapazitäten liest und auf den Chip-Marktplattformen feststellt, dass sich die prognostizierten Lieferzeiten schlagartig erhöhen, hätte er vielleicht früher die Puffer aufgefüllt. Auch wenn kein Manager der Welt diese Rechercheleistung stemmen kann – KI kann genau das. Web Scraping ist die Methode, mit der künstlich intelligente Tools Internetquellen nach gezielten Schlagworten durchforsten.

Diese geben Alarm, lernen hinzu und speisen ein Frühwarnsystem. Katastrophen können nicht verhindert werden, aber wenn China Siliziumfabriken schließt oder andere Black-Swan-Ereignisse am Anfang der Wertkette eintreten und Brancheninsider gleichzeitig im eigenen Blog über den Boom bei Unterhaltungselektronik berichten, kann KI zumindest den Hinweis geben, dass Angebot und Nachfrage gefährlich auseinanderdriften – lieber also die Pufferbestände frühzeitig erhöhen. Genau für diesen Anwendungsfall gibt es erprobte Algorithmen, welche sich an die spezifischen Herausforderungen für jedes Unternehmen anpassen lassen.

Der TCW Ansatz

TCW hat einen Ansatz für die Entwicklung eines Data Science Modells für Beschaffungs-Frühwarnsysteme entwickelt.

Modul 1: Lastenhefterstellung

Ausgehend vom Scoping des Handlungsbereiches entwickeln wir mit unseren Kunden gemeinsam das Lastenheft für das Pilotprojekt. Es fließt das Methodenwissen sowie das Erfahrungswissen von Supply Chain Experten ein. Es gilt eine klare Vorstellung von Zielen zu entwickeln, um zu erwartende Restriktionen sowie Deliverables und messbare KPIs zu erreichen. Ein hinreichend breites Expertenpanel sichert den Mehrwert des gesamten Piloten ab und sorgt für werthaltige Ideen im kreativen Prozess.

Modul 2: Hypothesenentwicklung

Jedes Data Science Modell, welches auf Analytics- oder Prädiktionselemente zurückgreift, baut auf einem Hypothesenmodell auf. Dieses entwickeln wir gemeinsam. Ein Hypothesenmodell ist die Summe der theoretischen Ursache-/Wirkungsbeziehungen, welche den Schlussfolgerungsprozess im Modell und das mathematische Modell formt. Es sind abhängige und unabhängige Variablen sowie Einflussfaktoren, Moderatoren und Gestaltungsvariablen zu definieren. Am Ende wird das Gesamthypothesenmodell konsolidiert.

Modul 3: Data Science Modellentwicklung

Es ist zwischen Coding und No-Code-Elementen zu unterscheiden. Hierzu stehen standardisierte TCW-Tools zur Verfügung, die je nach Anforderung eingesetzt werden können. Zudem existieren spezifisch entwickelte Tool-Bausteine, die hierfür verwendet werden können. Wichtig ist auch die Auswahl der Datenquellen und die Aufstellung des Data Cubes. Ziel ist es, das Datenmodell für einen abgegrenzten Trainingsbereich anzulegen.

Modul 4: Modell-Training und Verbesserung

Das Modell ist kontinuierlich zu testen und anhand von Trainingsdaten zu verbessern. In vielen Fällen geschieht ein Training anhand von semantisch-/numerischen Tags bis das Modell mit genug musterrelevanten Trainingszusammenhängen bespielt wurde. Dann kann ein lernender Algorithmus (z.B. k-Means-Clustering, Hauptkomponentenanalyse, Assoziationsanalyse, Soziale Netzwerkanalyse, A/B-Test, Abnehmendes-Epsilon-Strategie, vielarmige Banditen) mit existierenden Wenn-Dann-Zuordnungen trainiert werden.

Modul 5: Maßnahmen- und Entscheidungs-Toolbox

Handlungsschwellen, Maßnahmenbaukästen und eine Toolbox sind notwendig, um aus den Indikationen des Data Science Modells bessere Entscheidungen treffen zu können. Hierfür sind Interpretationsregeln für den Modell-Output zu definieren und zudem Entscheidungsschwellen im Modell und Trigger-Punkte festzulegen. Durch die Entwicklung eines Handlungskataloges und die Abgrenzung von Handlungsszenarien wird sichergestellt, dass das Data Science Modell einen Einfluss auf die bessere Entscheidungskompetenz unserer Kunden hat

Modul 6: Modell-Rollout

Die meisten unserer Kunden unterstützen wir beim Modell-Rollout. Dies umfasst die Entwicklung eines Anforderungskataloges für die Verankerung in den Fachbereichen. Fazit: Wer heute von Überraschungsmomenten spricht, ignoriert die mächtigen KI-Instrumente, die heute schon funktionieren. Um vorherrschende Muster aufzubrechen und neue Denkansätze zu verankern, kann eine externe Sicht der Dinge und ein breites Hinterfragen des Status quo nützlich sein. Gerne unterstützen wir Sie dabei!

Kontaktieren Sie uns unter

Beratungsleistungen

Publikationen

-

Data Science und künstliche Intelligenz

Leitfaden zur Einführung von Data Science im Unternehmen: Tools, Fallstudien und Methoden -

Data Science

Wie lässt sich die fünfte industrielle Revolution im Unternehmen managen? -

Innovationsbeschleuniger Krise

Krisenmanagement - Hochlaufkurve - Wachstumspfade

Praxisbeispiele

- Erfolgreiche Implementierung von Data Science im Einkauf

- Lektionen der Data Science Einführung: Das Modell des smarten Übersetzers mit TCW nutzen

- Data Science Implementierung leicht gemacht: Das können Sie von den Best-Practice-Unternehmen für die Implementierung lernen

Video: CW Purchasing Complexity Radar: Big Data im Einkauf nutzen

Video: Smartes Bestandsmanagement mit TCW: Bestände-Halbe durch Big Data und künstliche Intelligenz